Mit AMD-Technik: Cray baut 1,5-Exaflops-Superrechner für Oak Ridge

Ziel Top500-Spitze: Der 1,5-EFlops-Bolide "Frontier" startet 2021 mit AMD Epyc, Radeon Instinct und Infinity Fabric am US-Nationallabor Oak Ridge.

2021 wird sehr spannend für AMD und Intel: Am Oak Ridge National Laboratory (ORNL) geht dann Crays "Frontier"-Supercomputer mit 1,5 Exaflops Rechenleistung nur aus AMD-Chips in Betrieb. Ebenfalls für 2021 schon geplant ist auch "Aurora" mit Intel-Technik [1] – wiederum von Cray gebaut.

Während bei Aurora bisher nur von einer Rechenleistung im Exaflops-Bereich die Rede ist, legt sich AMD schon auf 50 Prozent mehr fest. Und für den Auftraggeber, das US-Department of Energy (DoE), hat das militärisch und geopolitisch bedeutsame Supercomputer-Wettrüsten gegen China [2] höchste Priorität. Dafür fließen auch hunderte Millionen US-Dollar Fördermittel [3] unter anderem an AMD, Cray, IBM, Intel und Nvidia.

(Bild: AMD)

Sowohl Aurora am Argonne National Lab (ANL) als auch Frontier nutzen Crays "Shasta"-Konzept für die Hochgeschwindigkeitsverbindung zwischen den einzelnen Cluster-Knoten (Slingshot). Intern wiederum arbeiten sowohl Frontier als auch Aurora mit Kombinationen aus Prozessoren und Rechenbeschleunigern: Bei AMD sind das ein speziell optimierter Epyc mit kommenden Zen-2- oder Zen-3-Kernen sowie je vier Radeon-Instinct-Beschleuniger pro CPU. Intel hingegen will die für 2020 angekündigten Xe-GPUs [4] verwenden sowie selbstverständlich die dann aktuellen Xeons.

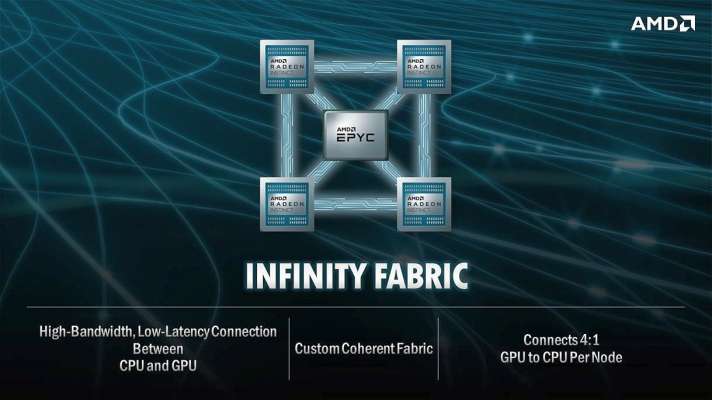

AMD Infinity Fabric

AMD hat ein besonderes Ass im Ärmel: Den schnellen Interconnect Infinity Fabric. Der kommt schon bisher in Zen-Prozessoren zum Einsatz, um mehrere Kern-Gruppen (CCX) intern zu koppeln oder auch zwei Epycs zu einem Zwei-Prozessor-System. Dazu lassen sich 64 der 128 PCI-Express-Lanes der Epycs in den Infinity-Fabric-Betriebsmodus umschalten. Auch die aktuellen 7-nm-Rechenbeschleuniger Radeon Instinct MI50 und MI60 nutzen Infinity Fabric [5], um mehrere davon zu koppeln.

Bei der kommenden Epyc-Generation mit Zen 2 [6] ermöglicht AMD nun auch die Cache-kohärente Kopplung per Infinity Fabric zwischen einer Epyc-CPU und vier Radeon-GPUs. Details zu Transferrate und Latenz verrät AMD allerdings nicht. Ebenfalls ist derzeit offen, ob die von PCIe (4.0) auf Infinity Fabric umschaltbaren Epyc-Lanes auch noch andere Betriebsmodi beherrschen, etwa CCIX [7] oder Gen-Z [8]: AMD ist Mitglied in beiden Industriegremien.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [9].

Interconnect-Gerangel

Nvidia und IBM verbinden in den aktuellen Top500-Spitzenreitern Summit und Sierra [10] die Tesla-V100-Beschleuniger mit den Power9-Prozessoren per NVLink 2.0 beziehungsweise OpenCAPI [11].

Intel plant für kommende Xeons und "Agilex"-FPGAs den kohärenten Interconnect Compute Express Link CXL [12] auf Basis von PCI Express 5.0, also mit 32 GBit/s pro Lane. OpenCAPI 3.0 arbeitet derzeit mit 25 GBit/s, PCIe 4.0 mit 16 GBit/s. CCIX soll mit 25 GBit/s starten.

Für die Verbindung zwischen den einzelnen Cluster-Knoten verwendet Cray bei Shasta den Slingshot-Interconnect mit Dragonfly-(Libellen-)Topologie und 200 GBit/s pro Port [13]. Mit dieser Rate läuft auch Infiniband HDR 200 Gb/s der Firma Mellanox, die Nvidia gekauft hat [14]. Und auch Intel will die hauseigene und in "F"(abric-)Xeons eingebaute Omni-Path Architecture mit OPA200 auf diese Geschwindigkeit bringen.

(ciw [15])

URL dieses Artikels:

https://www.heise.de/-4415699

Links in diesem Artikel:

[1] https://www.heise.de/news/Aurora-Exaflops-Supercomputer-mit-Intel-Technik-kommt-2021-4340094.html

[2] https://www.heise.de/news/Chinesische-CPU-Hygon-Dhyana-mit-AMD-Zen-fuer-Superrechner-4203408.html

[3] https://www.heise.de/news/PathForward-258-Millionen-US-Dollar-fuer-Exascale-Supercomputer-3745451.html

[4] https://www.heise.de/news/Bit-Rauschen-Intel-attackiert-mit-Xe-Grafik-AMD-und-Nvidia-vielleicht-4349992.html

[5] https://www.heise.de/news/AMD-Radeon-Instinct-MI50-und-MI60-PCIe-4-0-Beschleuniger-mit-7-nm-GPU-4213910.html

[6] https://www.heise.de/news/Erste-Details-zu-AMDs-7-nm-Zen2-Architektur-4213815.html

[7] https://www.heise.de/news/CCIX-Schnittstelle-fuer-Hardware-Beschleuniger-3215723.html

[8] https://www.heise.de/news/Konsortium-fuer-verteilten-Server-Speicher-ohne-Intel-3346935.html

[9] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[10] https://www.heise.de/news/Supercomputer-erste-ARM-und-Epyc-Rechner-in-der-Top500-Liste-4218568.html

[11] https://www.heise.de/news/OpenCAPI-Kohaerenter-Interconnect-fuer-Hardware-Beschleuniger-3350538.html

[12] https://www.heise.de/news/Interconnect-Gerangel-Nvidia-kauft-Mellanox-4335128.html

[13] https://www.cray.com/blog/meet-slingshot-an-innovative-interconnect-for-the-next-generation-of-supercomputers/

[14] https://www.heise.de/news/Interconnect-Gerangel-Nvidia-kauft-Mellanox-4335128.html

[15] mailto:ciw@ct.de

Copyright © 2019 Heise Medien