Salesforce: KI-Sprachmodelle verantwortungsvoll einsetzen

Salesforce formuliert Richtlinien für sicheren und verantwortungsbewussten Umgang mit KI, maskiert sensible Daten im Prompt und checkt die Ausgabe auf Fehler.

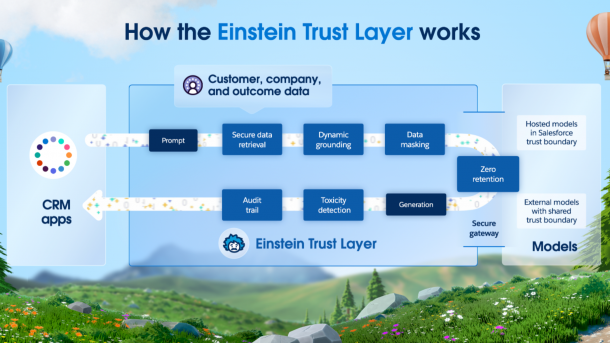

Der "Einstein Trust Layer" beschreibt eine Architektur, um den Prompt für ein KI-Sprachmodell sowie dessen Ausgabe auf sensible, falsche und potenziell schädliche Daten zu überprüfen.

(Bild: Salesforce)

Der Anbieter von CRM- und Web-Marketing-Software Salesforce will den Einsatz von KI-Sprachmodellen (Large Language Models, LLMs) so gestalten, dass Unternehmen sie sicher mit den Daten ihrer Kunden betreiben können. Dafür formuliert das Unternehmen Richtlinien und entwickelt Software, die zum Ziel hat, KI-Modelle verantwortungsvoll einzusetzen.

Den "Einstein Trust Layer" präsentierte Salesforce-CEO Marc Benioff im Rahmen der Hauskonferenz Dreamforce 2023 in San Francisco. Nach einem Jahr ungezügelter Wildweststimmung zeigt Salesforce damit, wie sich das zuweilen erratische Verhalten von ChatGPT & Co einhegen lässt.

Videos by heise

Fünf Prinzipien für den LLM-Einsatz

Salesforce hat fünf Prinzipien für den Umgang mit Künstlicher Intelligenz (KI) formuliert. Demnach muss die Ausgabe eines LLMs erstens sachlich richtig und zweitens ressentiment- und vorurteilsfrei ausfallen. Das KI-Modell muss ferner im Einverständnis mit den Nutzern, denen die Daten gehören, eingesetzt werden. Im Zweifelsfall zählt außerdem das Urteilsvermögen eines Menschen mehr als das der KI.

Als fünftes Prinzip formuliert Salesforce Nachhaltigkeit. Das bedeutet, dass beispielsweise der Einsatz eines kleineren Modells mit geringerem Energiebedarf Vorrang hat, wenn es für eine bestimmte Aufgabe ausreicht.

"Your data is not our product."

Ein Kernpunkt der Sicherheitsarchitektur von Salesforce ist, dass personenbezogene Daten nicht das Unternehmen verlassen dürfen, das die Software einsetzt. "Your data is not our product", Ihre Daten sind nicht unser Produkt, bekräftigt der CRM-Anbieter.

Falls ein LLM Zugriff auf personenbezogene Daten bekäme, würde es im mindesten Fall auf Kosten der Endnutzer aus ihnen lernen, also schlauer werden. Im schlimmsten Fall würden beispielsweise Kreditkarteninformationen von Nutzern eines Webshops geleakt.

Der Prompt erhält nicht alle Daten

Der Einstein Trust Layer von Salesforce implementiert verschiedene Komponenten, um LLMs im Rahmen der Salesforce-Software sicher einzusetzen, sei es intern oder extern gehostet. Das Unternehmen verspricht zunächst, personenbezogene Daten im Rahmen der "Shared Trust Boundary" niemals außerhalb von Salesforce zu speichern. Bevor die Software einen Prompt an ein LLM sendet, soll eine Ebene fürs "Data Masking" außerdem wichtige Endkundeninformationen filtern und maskieren. Sensible Daten wie Kreditkarteninformationen werden nicht an ein LLM weitergegeben.

Darüber hinaus soll der Einstein Trust Layer vor Fehlverhalten eines LLMs schützen. Eine weitere Ebene soll prüfen, ob die künstliche Intelligenz beispielsweise falsche Informationen halluziniert oder diskriminierende Ansichten reproduziert. Der Betreiber überprüft nach eigenen Angaben sowohl den Prompt als auch die LLM-Ausgabe auf potenziell schädliche Inhalte; gemeint sind in diesem Fall diskriminierende oder vorurteilsbehaftete.

Hinweis: Salesforce hat die Reisekosten des Autors zur Dreamforce übernommen. (akr)