DeepSeek soll V3 mit viel stärkerer Nvidia-Hardware entwickelt haben

Die Entwicklung von DeepSeek-V3 war vermutlich viel teurer als suggeriert. Die Firma soll Zugriff auf 60.000 GPUs haben.

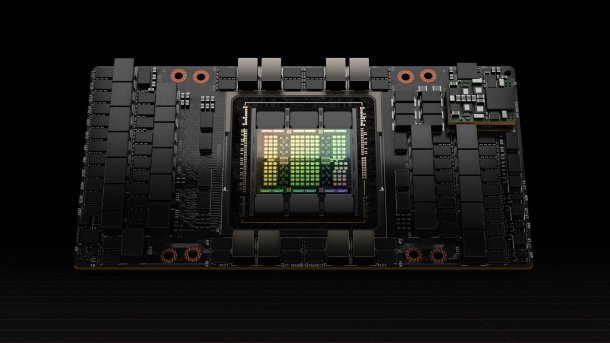

Die USA verbieten zwar den Verkauf des gezeigten H100-Beschleunigers nach China, über Importe soll DeepSeek trotzdem an 10.000 Stück gelangt sein.

(Bild: Nvidia)

DeepSeek soll Zugriff auf Zehntausende GPU-Beschleuniger zur Entwicklung der eigenen KI-Modelle haben, darunter auch H100-GPUs, die unter die US-Exportverbote fallen. Die kolportierten Kosten von knapp 5,6 Millionen US-Dollar für DeepSeek v3 stellen vermutlich nur einen kleinen Teil der Gesamtrechnung dar.

Im Paper zum V3-Modell schreibt DeepSeek von einem vergleichsweise kleinen Rechenzentrum mit 2048 H800-Beschleunigern von Nvidia. Die Firma rechnet mit hypothetischen Mietkosten von 2 US-Dollar pro Stunde und H800-GPU. Bei aufsummiert knapp 2,8 Millionen Rechenstunden (verteilt auf 2048 GPUs) kommen die 5,6 Millionen US-Dollar zustande.

Die Entwickler selbst führen allerdings eine Einschränkung an: "Bitte beachte, dass die oben genannten Kosten nur das offizielle Training von DeepSeek-V3 beinhalten und nicht die Kosten, die mit früheren Forschungs- und Ablationsexperimenten zu Architekturen, Algorithmen oder Daten verbunden sind."

50.000 Hopper- und 10.000 Ampere-Beschleuniger

Semianalysis hat sich mit einer realistischen Kostenaufstellung beschäftigt. Laut den Analysten hat DeepSeek über das Mutterunternehmen High-Flyer Zugriff auf etwa 60.000 Nvidia-Beschleuniger: 10.000 A100 aus der Ampere-Generation, bevor die US-Exportbeschränkungen in Kraft traten, 10.000 H100 vom Graumarkt, 10.000 für China angepasste H800 und 30.000 H20, die Nvidia nach neueren Exporteinschränkungen auflegte.

Der Scale-AI-CEO Alexandr Wang sagte kürzlich in einem Interview mit CNBC, dass DeepSeek 50.000 H100-Beschleuniger nutzen würde (ab Minute 2:40). Dabei könnte es sich um ein Missverständnis handeln: Die H100, H800 und H20 (zusammen angeblich 50.000) sind alle Modelle aus der Hopper-Generation, aber in unterschiedlichen Ausführungen.

H100 ist der Standardtyp für den Westen. Bei der H800 bremste Nvidia aufgrund von Exportbeschränkungen den Nvlink zur Kommunikation zwischen mehreren GPUs. Die H20 folgte aufgrund neuer Beschränkungen mit stark reduzierter Rechenleistung, aber ungedrosseltem Nvlink. Zudem nutzt sie den maximal möglichen Speicherausbau mit 96 GByte High-Bandwidth Memory (HBM3) und einer Übertragungsrate von 4 TByte/s.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Hoher ausgeklammerter Entwicklungsaufwand

Semianalysis rechnet vor, dass die notwendigen Server für die 60.000 GPUs etwa 1,6 Milliarden US-Dollar kosten. Auch wenn man die Kosten auf mehrere Jahre umlegt, wäre der Anteil für DeepSeek-V3 signifikant. Die Betriebskosten kommen obendrauf. Nicht eingerechnet sind die Gehälter der Entwicklungsteams.

96 Prozent der von DeepSeek genannten 5,6 Millionen US-Dollar entfallen nach eigenen Angaben auf das Pre-Training. Dabei wird das finale zugrundeliegende Modell trainiert. Den vorherigen Entwicklungsaufwand inklusive aller eingeflossenen Neuerungen von DeepSeek-V2 ignoriert das Paper.

Allein die Entwicklung der Caching-Technik Multi-Head Latent Attention (MLA) soll Monate beansprucht haben. Dabei komprimiert das KI-Modell alle generierten Token, damit es bei neuen Abfragen schnell auf die Daten zugreifen kann, ohne viel Speicherplatz zu beanspruchen.

Eine zweite Neuerung dürfte ebenfalls einige Ressourcen in Anspruch genommen haben: "Dual Pipe". DeepSeek nutzt einen Teil der Streaming-Multiprozessoren (SMs) in Nvidias GPUs als eine Art virtuelle Data Processing Unit (DPU), wie Nextplatform herausstellt. Sie kümmern sich unabhängig vom Prozessor um die Datenbewegungen in und zwischen den KI-Beschleunigern – mit viel geringeren Wartezeiten als beim Einsatz von CPUs, was die Effizienz steigert.

Im Paper zum mächtigeren R1-Modell macht DeepSeek keinerlei Angaben zur eingesetzten Hardware. Hier wäre der Einsatz eines kleinen Rechenzentrums noch unglaubwürdiger. Ausgehend von einem X-Beitrag häuften sich zuletzt Meldungen, dass DeepSeek für R1 auch KI-Beschleuniger von Huawei verwenden könnte.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(mma)