Nvidia-Chef äußert sich erstmals zum DeepSeek-Ausverkauf

Investoren hätten DeepSeeks Errungenschaft missinterpretiert, sagt Nvidia-Chef Jensen Huang. Für das Post-Training sei weiterhin starke Hardware notwendig.

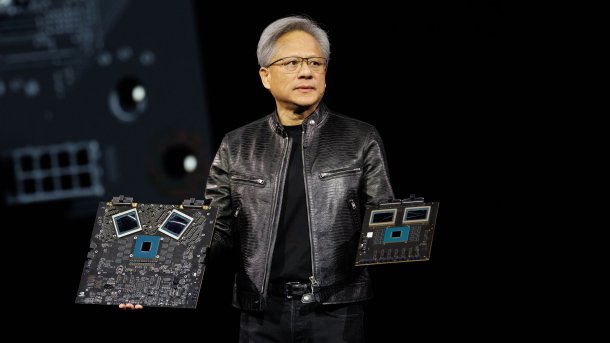

(Bild: Nvidia)

Nvidias Chef Jensen Huang spricht zum ersten Mal selbst über den vorübergehenden Aktienausverkauf nach der Vorstellung neuer DeepSeek-KI-Modelle. Im Januar 2025 machten Schlagzeilen die Runde, dass neue Trainingsmechanismen den Bedarf nach KI-Beschleunigern erheblich reduzieren könnten. Nvidias Börsen-Marktkapitalisierung fiel infolgedessen um über 600 Milliarden US-Dollar – inzwischen ist die Firma allerdings schon wieder auf Wachstumskurs.

In einem Video-Interview sagt Huang (ab Minute 58:00), dass Investoren die Tragweite falsch eingeschätzt hätten: "Aus der Sicht eines Investors gab es ein mentales Modell, dass die Welt aus Pre-Training und dann Inferenz bestand. Und Inferenz bedeutete, dass man einer KI eine Frage stellt und sie einem sofort eine Antwort gibt. Ich weiß nicht, wessen Schuld das ist, aber offensichtlich ist dieses Paradigma falsch."

Post-Training laut Huang am wichtigsten

Unter Pre-Training bezeichnet man das Training eines Basismodells, das grundlegend Fragen beantworten kann. Im Falle von DeepSeek ist dies das KI-Modell DeepSeek-V3. "Der wichtigste Teil der Intelligenz, wo man lernt, Probleme zu lösen", ist laut Huang aber das sogenannte Post-Training – dahinter stecken Mechanismen, um ein KI-Modell mächtiger zu machen.

Weit verbreitet sind derzeit unterschiedliche Varianten des Reinforcement Learnings: Das Baismodell gibt unterschiedliche Antwortoptionen und lernt durch Dritte, welche der Antworten am besten sind. Im Falle von DeepSeek spielten zwei KI-Modelle ihre Fragen und Antworten hin und her, womit das Reasoning-Modell DeepSeek-R1 entstand.

Videos by heise

DeepSeek machte lediglich zum V3-Modell Angaben über die eingesetzte Hardware. Allerdings gibt es auch hier Hinweise, dass im Hintergrund viel stärkere Server zum Einsatz kamen. Zu den eingesetzten Beschleunigern beim R1-Training schweigen sich die Entwickler aus – was Huangs Argumentation stützt.

(mma)