33C3: Hohe Hürden auf dem Weg zu einer Ethik fürs autonome Fahren

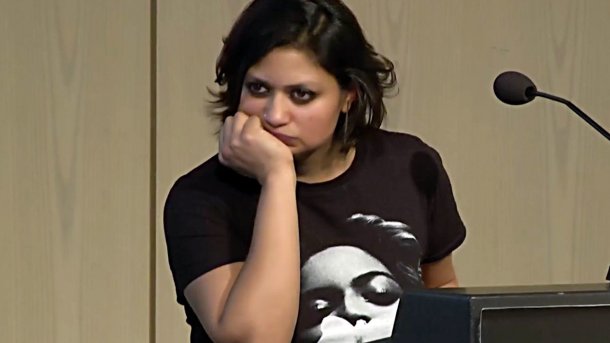

Die Kulturwissenschaftlerin Maya Indira Ganesh hat auf dem Hackerkongress das Bestreben hinterfragt, moralische Entscheidungen in Programme einzubauen. Mindestens das Schwarz-Weiß-Prinzip müsse dabei zwangsläufig versagen.

Politiker und Forscher suchen angesichts des Hypes rund um das autonome Fahren und aus Angst vor Killer-Robotern händeringend nach einer Ethik für Maschinen. Bundesverkehrsminister Alexander Dobrindt (CSU) will gar durch eine eigene Wissenschaftlerkommission klären lassen, wie computergesteuerte Fahrzeuge in Gefahrensituationen Prioritäten setzen sollten und wie es sich bei Unfällen mit der Haftung verhält.

Maya Indira Ganesh, die derzeit an ihrer Doktorarbeit zur Debatte über Ethik im Kontext selbstfahrender Autos an der Leuphana-Universität Lüneburg sitzt, sieht einschlägige Initiativen vor großen Problemen stehen. Sie halte es für mehr als fraglich, "ob moralische Entscheidungen in Programme eingebaut werden können", erklärte die Kulturwissenschaftlerin und Aktivistin am Donnerstag auf dem 33. Chaos Communication Congress (33C3) in Hamburg. Meist gehe es dabei darum, möglichst einfache Lösungen nach dem Schwarz-Weiß-Prinzip etwa mithilfe binärer logischer Verknüpfungen zu finden. Viele versuchten so, ein völlig "antiquiertes Ideal" von Ethik in Maschinen einzuprogrammieren. Ein solches Unterfangen sei in der komplexen Lebenswelt zum Scheitern verurteilt.

Das hierzulande als Weichenstellerfall bekannte Trolley-Problem werfe eine alte philosophische Frage rund um ein schweres moralisches Dilemma auf, brachte die auf dem Kongress unter ihrem Pseudonym "mayameme" angekündigte Forscherin ein Beispiel. Kollegen vom MIT hätten darauf basierend einen Online-Test für eine moralische Maschine entwickelt, über den Menschen in vielerlei Fällen entscheiden sollten, ob sie mit einem Fahrzeug in einer ausweglosen Situation etwa lieber Diebe oder Babys beziehungsweise Katzen oder Hunde töten wollten. Immer befinde man sich dabei in einer schier unlösbaren Zwickmühle, wen man opfere.

Ethischer Meta-Bot

Künftig solle eine Software diese Entscheidungen treffen, "obwohl wir es nicht können", veranschaulichte Ganesh die Schwierigkeiten rund um ein derartiges Konzept. Jeder von einem Autopiloten verursachte Unfall werde damit zu einer überaus vertrackten Geschichte. Die Wissenschaftler Amitai und Oren Etzioni hätten derweil einen ethischen Meta-Bot ins Spiel gebracht, der als eine Art übergeordneter Schutzengel die anderen Algorithmen und Roboter überwachen solle.

Für die Ethikforscherin ist das eine reichlich naive Vorstellung. Sie hält es lieber mit der kritischen Cyborg-Theoretikerin Donna Haraway, der zufolge die Technologie immer wieder genauso gern wie fälschlich als Retterin vor ihren eigenen "bösen", aber "cleveren" Kindern hochstilisiert werde. Selbst bei sogenannten "lernenden Maschinen" müsse man schließlich immer im Hinterkopf behalten, dass diese vor allem die Einstellungen und Vorurteile derjenigen widerspiegelten, die die grundlegenden Datentrainingssets zur Verfügung stellten. Derlei Systeme seien dann zwar sehr gut darin, spezifische Aufgaben abzuarbeiten oder zu lösen. Kreatives menschliches, auch einmal von den Regeln abweichendes Verhalten bleibe ihnen aber fremd.

Keine universale Maschinenethik

Für Ganesh ist damit klar, dass sich humanistische Werte nicht in Software einbinden lassen. Ihr zufolge ist es äußerst schwer, menschliche Moral und Sittenlehre Maschinen einzuimpfen. Das moderne humanwissenschaftliche Verständnis gehe davon aus, dass Ethik aus dem Kontext heraus im Zusammenspiel vieler Akteure entstehe und es sich dabei um eine "komplexe kulturelle Errungenschaft" handle. Diese algorithmisch nachzubilden, könne allenfalls in einem nicht weniger facettenreichen kollaborativen Ansatz unter Berücksichtigung verschiedenster Modelle eventuell ansatzweise erreicht werden. Ein Autobauer könne aber sicher nicht im Alleingang eine universale Ethik schaffen und maschinell durchdrücken.

Erfreut zeigte sich die Wanderin zwischen den Kulturen, dass diese Ansicht offenbar langsam auch im Bereich der Ingenieurwissenschaften hoffähig werde. Sie verwies auf einen Mitte Dezember veröffentlichten Berichtsentwurf des Institute of Electrical and Electronics Engineers (IEEE) zu "ethisch ausgerichtetem Design", der in die richtige Richtung gehe und Vereinfachungen vermeide. Das Standardisierungsgremium will mit der Initiative eine Leitlinie entwickeln, anhand der das menschliche Wohlbefinden im Sinne des Konzepts der Eudaimonie aus der altgriechischen Philosophie in autonomen und auf Künstlicher Intelligenz aufbauenden Systemen Priorität haben soll. (ea)