Face ID: iPhone X kann Gefühlslage des Betrachters in Echtzeit überwachen

Ein Hackerteam hat eine App entwickelt, die über die TrueDepth-Gesichtskamera ermittelt, ob der Benutzer gerade traurig, überrascht oder sauer ist. Werbetreibende lecken sich nach solchen Möglichkeiten die Finger.

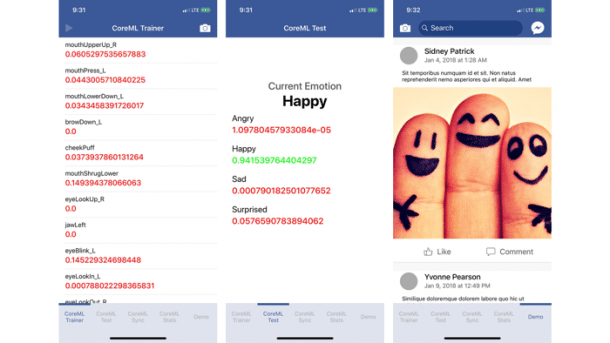

(Bild: Entwickler)

Dass es bei Apps, die auf dem iPhone X die Gesichtserkennungsfunktion Face ID nutzen, ein Missbrauchspotenzial gibt, hatten Entwickler bereits angemerkt. Auf einem Hackerthon in Westkanada hat ein Team um die Entwickler Lansi Chu, Kevin Yap, Nathan Tannar und Patrick Huber mit Loki nun eine Proof-of-Concept-App präsentiert, die zeigt, wie dies in der Praxis aussehen könnte: Das Tool erkennt die Stimmungslage des iPhone-Benutzers in Echtzeit.

Ultimative Werbeüberwachung

Werbetreibende und Marketingleute wünschen sich schon seit langem, automatisiert und ohne Zeitverzug erkennen zu können, wie ihre Reklame beim Benutzer ankommt. Mit Code wie dem von Loki wäre dies möglich.Technisch basiert der Ansatz auf maschinellem Lernen: Zunächst wurden der App Nutzer (knapp 100) vorgeführt und deren Gefühlslage klassifiziert. Aktuell unterscheidet das System die vier Emotionen "wütend" (angry), "glücklich" (happy), "traurig" (sad) sowie "überrascht" (surprised). Nach dem Trainingsprozess zeigte sich, dass Loki die Gefühlslage mit hoher Genauigkeit sowie in Echtzeit ausgeben konnte.

Code steht auf GitHub bereit

Als Anwendungsbeispiel nennt das Hackerteam um Chu & Co. Werbung im sozialen Netzwerk Facebook (siehe Video). Hier könnten Reklameanbieter auf die Idee kommen, ihre Kampagne an die aktuelle Gefühlslage des Betrachters anzupassen. Alternativ wäre auch eine Reaktionsüberprüfung auf eine Anzeige denkbar.

Der Code von Loki liegt auf GitHub zum Ausprobieren und Weiterentwickeln bereit. Der Backend-Server benötigt Python 2 und Postgres 9.4 oder höher.

Bevor ein Tool wie Loki tatsächlich zur Anwendung kommt, müsste Apple Entwicklern dies jedoch zuerst erlauben. Aktuell verbieten die Developer-Bedingungen des Konzerns die Nutzung des 3D-Erkennungsmoduls (TrueDepth-Kamera) für Marketingzwecke.

Schnittstelle erfasst 52 Mikrobewegungen

Apple selbst stellt Entwicklern aber eine Schnittstelle bereit, über die 52 Mikrobewegungen des Gesichtes ausgewertet können – auch über diese ließen sich Rückschlüsse auf die Gefühlslage des Benutzers ermitteln.

Rinat Khanov, Entwickler des Tools MeasureKit, das die Schnittstelle nutzt, hatte im Dezember befürchtet, dass solche Apps womöglich im Review-Prozess "durchrutschen" könnten. Allerdings betont Apple, dass man sich solcherlei Anwendungen genau ansehen will.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(bsc)