Von Hardware zu Hirnware

Künstliche neuronale Netze schaffen heute Aufgaben, die noch vor zehn Jahren für Computer unlösbar waren. Doch das Gehirn hält noch viele weitere Kniffe bereit.

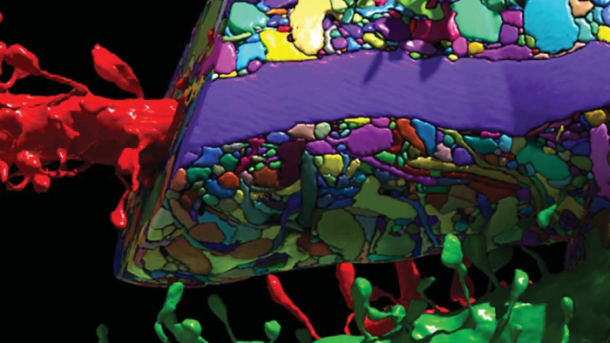

(Bild: Courtesy of Lightman Lab)

- Christian Honey

Selbstfahrende Autos, Gesichtserkennung, Sprachassistenten – tiefe neuronale Netze verblüffen mit immer besseren Leistungen. Ihre Arbeitsweise folgt den Prinzipien biologischer Nervensysteme: Neuronen empfangen Signale über Synapsen, verrechnen sie und schicken das Resultat an andere Neuronen. Sie sind in Schichten aufgebaut, und sie lernen, indem sie die Effizienz verändern, mit der Synapsen die Impulse übertragen. So weit, so hirnartig.

Trotzdem sind künstliche neuronale Netzen extrem vereinfachte Abbilder dessen, was Neurowissenschaftler in Gehirnen tatsächlich beobachten. Gehirne sind wesentlich stärker vernetzt, und sie schicken Impulse zwischen ihren Schichten hin und her. Echte Neuronen sind zudem keine eindimensionalen Integrationseinheiten, sondern räumlich ausgedehnte Wesen mit Ästen voller Synapsen. Und sie arbeiten nicht nur digital, sondern integrieren Informationen auch analog.

Beste Supercomputer

Einiges spricht dafür, dass diese Unterschiede der Grund dafür sind, warum selbst die modernsten neuronalen Netze auf den besten Supercomputern nicht mit der Auffassungsgabe einer Dreijährigen mithalten. Deshalb arbeiten Industrie und Forschung nun an "neuromorpher" Hardware, die Architektur und Arbeitsweise des Gehirns so exakt nachbaut, wie es die heutige Chiptechnologie erlaubt. Diese neuromorphen Maschinen sollen kontinuierlich aus Sinnesdaten lernen und Hirnforschern helfen, unser Denken besser zu verstehen.

TrueNorth heißt einer der Ansätze. Der Chip ist das Produkt des SyNAPSE-Projekts der US-Forschungsagentur Darpa, verwirklicht von IBM, Hewlett-Packard und dem Hughes Research Lab. Er besteht aus einem Netzwerk aus 4096 "neurosynaptischen" Rechnerkernen, die parallel die Aktivität von rund einer Million Neuronen simulieren. Jedes Neuron kann 256 Inputs von anderen integrieren und hat dafür individuell programmierbare Input-Kanäle (Synapsen).

Neuromorph an TrueNorth ist, dass der Chip mit einem alten Prinzip der Rechnerarchitektur bricht: der Trennung von Prozessor und Speicher. Denn auch im menschlichen Gehirn ist jede der 100 Milliarden Nervenzellen zugleich Speicher und Prozessor einer kleinen Menge an Informationen. In TrueNorth hat deshalb jeder Rechenkern seinen eigenen Speicher, der den Zustand der Neuronen und Synapsen kontinuierlich aktualisiert. Das ist kein perfektes Abbild, aber dem Aufbau des Gehirns deutlich näher als jeder klassische Rechner.

Arbeitsweise wie ein Gehirn

Dennoch wäre TrueNorth ohne konventionelle Computer aufgeschmissen. Denn der Chip selbst kann keinen Lernalgorithmus ausführen. Alles Training, zum Beispiel für das Erkennen von Objekten, findet auf anderen Computern statt, die ein Software-Modell von TrueNorth simulieren. Das Resultat, also die Verbindungsstärken (fachsprachlich Gewichte) der Synapsen, werden nach dem Training auf die echten Rechnerkerne von TrueNorth kopiert.

Neben dem Aufbau ähnelt auch die Arbeitsweise von TrueNorth dem Gehirn. Denn statt einem einheitlichen Prozessortakt zu folgen, arbeiten seine Rechnerkerne "eventbasiert": Wie im Nervensystem generieren die Neuronen als Output binäre Impulse, Aktionspotenziale oder "Spikes". Der Vorteil: Nur wenn ein Neuron einen Spike als Input bekommt, wird sein Rechnerkern aktiv. Das macht TrueNorth außergewöhnlich energieeffizient. Er verbraucht mit 70 Milliwatt im Vergleich zu handelsüblichen Chips nur rund ein Zehntausendstel.

"Auch in biologischen neuronalen Netzen feuern Neuronen extrem selten", sagt Karlheinz Meier, Professor für Experimentalphysik an der Uni Heidelberg. Er arbeitet im Rahmen des Human Brain Project selbst an einem neuromorphen Chip, dem BrainScaleS, der ebenfalls digitale Spikes zur Kommunikation nutzt. "Spikes sind ein zentraler Grund dafür, dass Gehirne so energieeffizient sind", sagt Meier.

Ein weiterer Unterschied zwischen natürlichen und künstlichen neuronalen Netzen: In letzteren übernimmt das Lernen heute fast ausschließlich der sogenannte Backpropagation-Algorithmus. Dieser vergleicht für jeden Input den Unterschied zwischen gewünschtem und tatsächlichem Output des Netzwerks. Anhand dieses "Fehlers" berechnet er für jede der (oft vielen Milliarden) Synapsen eine kleine Fehlerkorrektur.

Tiefe neuronale Netze

Backpropagation hat tiefen neuronalen Netzen zum Durchbruch in der KI verholfen. Aber solch ein Algorithmus braucht eine zentrale Steuerung, und das Gehirn hat keine. Synapsen, die die Fehlerkorrektur selber erledigen, wären eine elegante und effiziente Lösung. Eine zentrale Voraussetzung dafür ist, dass Neuronen Feedback-Spikes aus höheren Hirnregionen erhalten, die sie mit Signalen vergleichen können, die aus tieferen Regionen einströmen, zum Beispiel aus den Sinnesorganen.

Und Feedback im Gehirn gibt's wie Berliner Bürger an der Currywurstbude. In biologischen neuronalen Netzen gilt fast immer: Wenn A mit B verbunden ist, dann ist es B auch mit A. Zugleich haben Gehirne viel weniger Schichten als ihre künstlichen Abbilder, für die 100 Schichten nichts Ungewöhnliches sind. "Ein Netzwerk mit zwölf Schichten und starkem Feedback kann womöglich ein Netzwerk mit 100 Schichten ohne Feedback abbilden", sagt Steve Furber von der University of Manchester. "Aber niemand weiß, wie man ein Netzwerk mit derart starkem Feedback analysieren soll."

Dazu hat er nun das Netzwerk SpiNNaker (Spiking Neural Network Architecture) gebaut. Es soll Hirnforschern und KI-Forschern eine Plattform bieten, um hochvernetzte Systeme zu erforschen. "Das Besondere an SpiNNaker ist, dass wir damit eine Konnektivität auf dem Niveau des Gehirns schaffen können", sagt Furber. SpiNNaker ist ein Monstrum von einem Rechner: 600 Platinen mit je 48 Chips und 18 Rechnerkernen pro Chip: macht rund eine halbe Million Rechnerkerne. Auf jedem Chip läuft eine Simulation von 16000 Neuronen – zusammen simulieren sie 460 Millionen Neuronen mit insgesamt 460 Milliarden Synapsen. Wie in TrueNorth basiert die Kommunikation in SpiNNaker auf Spikes. Allerdings sind die Chips selbst nicht neuromorph. SpiNNaker besteht aus konventionellen ARM-Prozessoren, wie sie heute in Smartphones eingesetzt werden. "Neuromorph ist bei SpiNNaker nur das hohe Maß an Vernetzung", sagt Furber.