Roboter müssen noch viel lernen

Autonome Systeme haben Entwicklungspotenzial. Wie aber kann das genutzt werden?

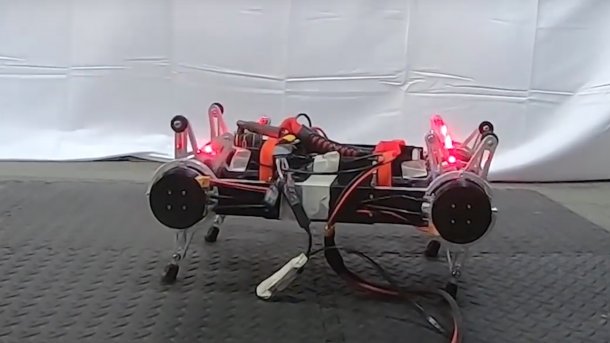

(Bild: University of California Berkeley / Youtube)

Verfahren des maschinellen Lernens haben der Künstlichen Intelligenz (KI) und der Robotik zu großer Aufmerksamkeit in der Öffentlichkeit verholfen. Auf einmal schien der lange Zeit verlachten KI alles möglich zu sein. Doch mittlerweile scheint der Hype abzuebben und es wird immer deutlicher, dass auch Lernmethoden ihre Grenzen haben.

Notwendige Modelle

So machte Angela Schöllig (University of Toronto) in ihrem Hauptvortrag auf der Konferenz Robotics: Science and Systems (RSS) in Freiburg deutlich, dass die Kontrolltheorie durch das maschinelle Lernen längst nicht überholt sei. Vielmehr müssten beide sich ergänzen, wenn Roboter unter vielfältigen und variablen Bedingungen zuverlässig funktionieren sollen.

Lernverfahren seien gut geeignet, um große Datenmengen zu verarbeiten und unbekannte Umgebungen zu erkunden, könnten aber nicht mit Grenzfällen umgehen oder Sicherheit garantieren – was wiederum die Stärke der modellbasierten Kontrollverfahren sei. Modelle seien erforderlich, um sich wiederholende Fehler zu verstehen und die Stabilität und Robustheit eines Systems zu gewährleisten. Maschinelles Lernen wiederum kann die Leistung des Systems kontinuierlich verbessern und seine Anpassungsfähigkeit an Veränderungen in der Umgebung steigern.

Grenzfall autonomes Fahren

Ein klassisches Szenario, in dem reine Lernverfahren an ihre Grenzen stoßen, ist das autonome Fahren: Es ist unrealistisch, ein Auto mehrere tausend Mal von der Klippe stürzen oder in Frontalzusammenstöße krachen zu lassen, bis es gelernt hat, solche Situationen zu meistern. Selbst 26 Millionen Trainingsbeispiele reichten nicht aus, um ein Auto sicher fahren zu lassen, sagte Mayank Bansal von der Firma Waymo. Es fehlten die Kollisionen und andere extreme Situationen.

Das System ChauffeurNet soll das Problem lösen, indem es kritische Fälle als synthetische Daten bereitstellt. Panpan Cai (National University of Singapore) stellte LeTS-Drive vor, bei dem ein teilweise beobachtbarer Markow-Entscheidungsprozess (POMDP) mit Deep Learning kombiniert wird, um ein Fahrzeug sicher über belebte Kreuzungen oder durch Menschenmengen zu steuern.

Optimierbares Lernen

Natürlich lässt sich auch beim Lernen selbst noch vieles optimieren. So sollen etwa Value Iteration Networks (VIN) die Übertragung des gelernten Verhaltens auf andere Umgebungen erleichtern und langfristigere Planung in den Lernprozess einbetten. Allerdings sei die Anwendung von VIN in realen Umgebungen bislang dadurch eingeschränkt, dass ihre Wirksamkeit auf kleine Domänen mit wenigen Dimensionen begrenzt sei, sagte Daniel Schleich (Uni Bonn). Dem wollen die Bonner Forscher durch die Einführung unterschiedlicher Abstraktionsebenen entgegenwirken: Die unmittelbare Umgebung des Roboters wird dabei detaillierter wiedergegeben als die weiter entfernte. Die Methode habe sich beim Test mit einem Rettungsroboter bewährt.

Tuomas Haarnoja (University of California Berkeley) stellte den Algorithmus Soft Actor-Critic (SAC) vor, mit dessen Hilfe ein vierbeiniger Roboter innerhalb von zwei Stunden das Laufen lernte. Obwohl auf flachem Untergrund trainiert wurde, war das erlernte Verhalten robust genug, um auch schiefe Ebenen und unebenen Boden zu bewältigen.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Die Forschungen, von denen Devin Schwab (Carnegie Mellon University) berichtete, bauen auf dem bei Google DeepMind entwickelten Algorithmus Scheduled Auxiliary Control (SAC-X) auf: Komplexes Verhalten wird dabei über Basisfertigkeiten gelernt – ähnlich einem Baby, das zunächst lernen muss, seine Gliedmaßen zu koordinieren und die Balance zu halten, bevor es sich ans Krabbeln oder Laufen wagen kann. Auf diese Weise ließen die Forscher einen Roboterarm das Spiel Ball-in-a-Cup lernen, bei dem ein Ball durch eine Schnur mit einem Korb verbunden ist und durch einen geschickten Schwung mit dem Korb eingefangen werden muss. Durchs Erlernen der Basisfähigkeiten habe der Roboter das Spiel achtmal schneller beherrscht, als wenn er sich allein auf visuelle Informationen gestützt hätte.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Siehe dazu auch:

(anw)