Vorausschauendes Fahren für autonome Autos

"Mündet nicht da vorne eine Straße ein? Vielleicht nehme ich doch lieber den Fuß vom Gas." Solche Schlüsse sollen auch Roboter ziehen können.

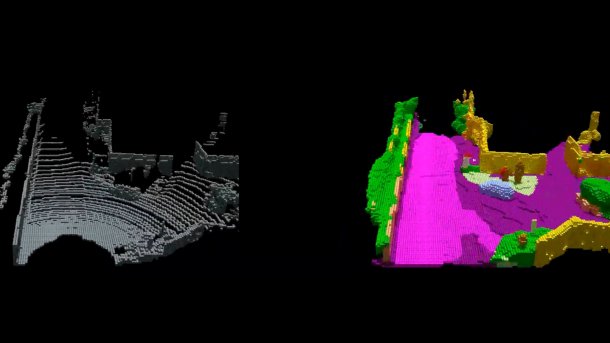

(Bild: semantic-kitti.org)

Was menschlichen Autofahrern mit den Praxisjahren in Bremsfuß und Schalterhand übergeht, ist fürs autonome Fahren noch ein Problem: das vorausschauende Fahren. Forscher der Universität Bonn wollen diese Fähigkeit nun auch autonomen Autos beibringen und haben dafür einen Algorithmus entwickelt, der LiDAR-Daten vervollständigt und interpretiert.

"Das Auto kann sich dadurch auf mögliche Gefahren frühzeitig einstellen", erläutert der Informatiker Prof. Dr. Jürgen Gall. Er leitet an der Uni Bonn die Arbeitsgruppe "Computer Vision", die zusammen mit seinen Uni-Kollegen vom Institut für Photogrammetrie und der Arbeitsgruppe "Autonome Intelligente Systeme" an der Lösung des Problems forscht, dass sich selbstfahrende Autos wie ein Fahrschüler in seiner ersten Stunde verhalten.

120.000 Punkte pro Umdrehung

Im Zentrum der Bonner Forschung stehen die von einem LiDAR erbrachten Daten der von ihm gescannten Umgebung. Der Strahl des LiDAR-Systems – ein rotierender Laser auf dem Dach der meisten autonom fahrenden Autos – wird von der Umgebung reflektiert. Das System misst, wann das reflektierte Licht auf den Sensor fällt, und berechnet aus der Laufzeit die Entfernung. "Pro Umdrehung erfasst das System auf diese Weise die Distanz zu rund 120.000 Punkten rund um das Fahrzeug", erklärt Gall. Allerdings "verdünnen" sich die Messpunkte mit zunehmender Entfernung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

"Die Universität Karlsruhe (KIT) hat vor einigen Jahren große Mengen von LiDAR-Daten aufgenommen, insgesamt 43.000 Scans", erklärt Dr. Jens Behley vom Institut für Photogrammetrie. "Wir haben nun jeweils Sequenzen von mehreren Dutzend Scans genommen und diese überlagert." Die so gewonnenen Daten enthalten also auch Punkte, die der Sensor erst erfasst hatte, als das Auto schon einige Meter weiter gefahren war.

"Diese überlagerten Punktwolken enthalten wichtige Informationen wie die Geometrie der Szene und die räumliche Ausdehnung der darin enthaltenen Objekte, die in einem einzelnen Scan nicht verfügbar sind", betont Martin Garbade vom Institut für Informatik. "Zusätzlich haben wir in ihnen jeden einzelnen Punkt beschriftet – also etwa: Dort ist ein Gehweg, da ein Fußgänger und dahinten ein Motorradfahrer." Die Wissenschaftler fütterten ihre Software mit einem Datenpaar: einem einzelnen LiDAR-Scan als Eingabe sowie den dazu gehörigen Überlagerungsdaten samt semantischer Information als gewünschte Ausgabe. Das wiederholten sie für mehrere tausend solcher Paare.

Fehlende Daten

Der Algorithmus habe so gelernt, einzelne Scans zu vervollständigen, fehlende Messwerte plausibel zu ergänzen und zu interpretieren. Rund die Hälfte der fehlenden Daten könne das Verfahren korrekt vervollständigen. Allerdings funktioniert die semantische Interpretation noch nicht so gut. Bei der Schlussfolgerung, welche Objekte sich hinter den Messpunkten verbergen, kommt der Rechner auf eine Trefferquote von maximal 18 Prozent.

"Bislang fehlte es schlicht an umfangreichen Datensätzen, mit denen sich entsprechende Verfahren aus der künstlichen Intelligenz trainieren lassen", betont Gall. "Wir schließen hier mit unserer Arbeit eine Lücke. Ich bin optimistisch, dass wir in den nächsten Jahren die Trefferquote bei der semantischen Interpretation deutlich steigern können." 50 Prozent hält er für durchaus realistisch, was einen enormen Einfluss auf die Qualität des autonomen Fahrens haben könnte.

Am kommenden Freitag wollen die Forscher den Algorithmus auf der International Conference on Computer Vision in Seoul vorstellen. (anw)