Fahren nach Gefühl

Sicherheit ist nicht alles – Assistenzsysteme sollten auch so fahren, dass sich Nutzer wohlfühlen. Forscher arbeiten deshalb an Autos, die sich auf die emotionalen Bedürfnisse ihrer Insassen einstellen.

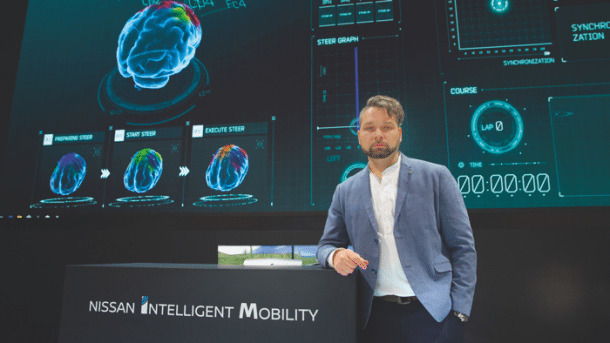

(Bild: Nissan)

- Frank Puscher

- Gregor Honsel

Las Vegas im Januar 2018: Auf einer Leinwand ist ein simuliertes Auto zu sehen, daneben die animierte Ansicht eines Gehirns. Plötzlich, vor einer Kurve, färbt sich das Gehirn rot: ein neuronales Gewitter. Der Passagier fühlt sich offenbar unwohl.

So etwas kann über Wohl und Wehe von Spurhalteassistenten oder autonomen Autos entscheiden. Denn deren Insassen möchten nicht nur sicher, sondern auch sanft chauffiert werden. Jedenfalls nicht so wie von der autonomen Mercedes-Limousine, die 2013 auf einer Testfahrt stur mit exakt 50 Kilometern pro Stunde auf ein Stadttor zuhielt, das nur wenig breiter war als sie selbst.

Die Mercedes-Ingenieure an Bord vertrauten damals – zu Recht – ihren Sensoren. Weniger nervenstarke Nutzer aber dürften nach solchen Erlebnissen schnell sämtliche elektronischen Helfer abschalten. Auch andere autonome Autos haben ihre Eigenheiten, wie die TR-Autorin Rachel Metz erfuhr: Der US-Anbieter Keolis etwa nervte mit ruckeligen Stop-and-go-Fahrten, Baidu mit übervorsichtigem Herumschleichen.

Auf der Präsentation in Las Vegas erfährt das Assistenzsystem ein Update, und das Gehirn färbt sich grün – das Fahrzeug hat sich auf die individuellen Präferenzen seines Passagiers eingestellt. Noch ist die Vorführung reines Marketing, um den Forschungsgegenstand zu illustrieren. Doch Lucian Gheorghe arbeitet daran, die Vision zu verwirklichen. Der Rumäne leitet das Forschungsprojekt "Brain to Vehicle" von Nissan. Gemeinsam mit der Ècole Polytechnique in Lausanne will er den perfekten Chauffeur erschaffen.

Doch wann und wobei genau wird es welchen Menschen an Bord zu bunt?

Dazu muss man zunächst einmal verstehen, was im Gehirn während der Fahrt vor sich geht. Dies ist das Spezialgebiet der Forscher in Lausanne. Sie arbeiten unter anderem mit EEG-Headsets, welche die Gehirnströme messen. Bisher fand solche Forschung vor allem im Labor statt, in einer genau kontrollierten Umgebung. "Wir haben nun Algorithmen entwickelt, die umgebungsbedingte Abweichungsmuster aus den EEG-Daten herausrechnen", sagt Gheorghe. Damit lassen sich Gehirnströme auch in dynamischen Umgebungen wie fahrenden Autos auswerten – oder in Fahrsimulatoren, wo Störeinflüsse gezielt eingeblendet werden.

Mittlerweile haben die Forscher viele Hundert Probanden im Simulator untersucht – oft zwei gleichzeitig im selben Raum mit dem gleichen Szenario, damit die gemessenen Datensätze vergleichbar sind. "Wir haben dabei ein Muster im EEG identifiziert, das wir Error-Related Potential nennen", sagt Gheorghe. Allerdings kann man aus Gehirnwellen noch nicht auf konkrete Emotionen schließen – Stress schlägt sich im EEG genauso nieder wie Freude. Und für Stress wiederum kann ein zu forsches oder ein zu zögerliches Fahren ausschlaggebend sein.

Wie also kommen Gheorghe und Millán dann an "Wohlfühldaten"? Im Grunde ist es ein Rechentrick: Sie unterstellen, dass es beim Autofahren keine positiven Abweichungen gibt, die durch das Verhalten des Fahrzeugs ausgelöst werden. Also ist jeder Ausschlag im ERP Ausdruck von Stress.

Ziel beim Feintuning eines Autopiloten ist es deshalb, so etwas wie eine "emotionale Nulllinie" zu erreichen. Nach dem Trial-and-Error-Prinzip drehen die Forscher so lange an Parametern wie Beschleunigung und Lenkausschlägen herum, bis sich die ERP-Ausschläge im Simulator minimieren. Eine weitere Stellschraube ist die Transparenz des Systems – ein Autopilot sollte immer genau erklären, was er gerade tut. Bei Nissan testet man gerade, wie weit sich das beruhigend auswirkt.

"Die Ergebnisse unserer Forschung fließen in die nächste Generation der Assistenzsysteme bei Nissan ein", sagt Lucian Gheorghe. Künftig ließen sich auch individuelle Fahrzeuge auf die Vorlieben ihrer Nutzer einstellen. Dies könnte beispielsweise beim Händler bei der Auslieferung geschehen. Allerdings ist das Verfahren sehr aufwendig: Bevor sich nutzbare Daten gewinnen lassen, muss das System auf das "Grundrauschen" eines Gehirns kalibriert werden. Entsprechend weit in der Ferne liegt diese Vision. Immerhin: Die nötige Hardware dazu wäre schon vorhanden. Gheorghe und sein Team haben ein eigenes Headset entwickelt, das dank Vorverstärker extrem feine Signale messen kann.

Um das Befinden der Insassen in Echtzeit zu erfassen, sind solche Headsets aber zu umständlich und unbequem. Doch es gibt auch andere Lösungen: Kameras und Mikrofone im Innenraum nebst Software zur Emotionserkennung. Als führend im Bereich der Emotionserkennung aus Gesichtern gilt das US-amerikanische Start-up Affectiva.

Sein System wird heute zur Müdigkeitserkennung eingesetzt, aber es dürfte kein allzu großer Schritt sein, auch das Befinden der Insassen zu ermitteln – und das Auto vorsichtiger fahren zu lassen, wenn ihnen offenkundig übel ist. "Unsere Systeme können inzwischen grundlegende emotionale Regungen auch über unterschiedliche Geschlechter, Altersstufen und Ethnien stabil erkennen", sagt CEO Rana el Kaliouby. Nach eigenen Angaben merkt die Software sogar, wenn etwa einem Beifahrer die Musik nicht gefällt.

Noch genauer wird die Emotionserkennung, wenn noch der akustische Kanal dazukommt. Genau darauf hat sich das Münchner Start-up Audeering spezialisiert. Es hat seine Algorithmen so verfeinert, dass es sogar aus Atemrhythmus und -intensität Schlüsse auf die Gefühle eines Menschen ziehen kann. "Bei der Emotionserkennung liegen wir im Bereich von 75 Prozent, was den menschlichen Erkennungsraten entspricht", sagt Gründerin Dagmar Schuller.

Das funktioniere aber nur, wenn der User viel spricht, etwa mit sich selbst, seinem Beifahrer oder dem Navigationssystem. Oder wüste Flüche von sich gibt. Sogar einige Krankheiten kann Audeering nach eigenen Angaben erkennen – Schnupfen mit einer Trefferquote von 80 Prozent, eine bestimmte Parkinson-Variante mit 92 Prozent.

Doch selbst wenn man die Emotionen der Insassen genau kennt, ist es schwer, daraus die richtigen Reaktionen abzuleiten. Das hat eine Umfrage von Nuance ergeben. Der Spezialist für Spracherkennung hat unter anderem Mercedes als Kunden, ist ebenfalls sehr interessiert an Informationen über die Gefühlswelt von Autofahrern und kooperiert mit Affectiva. Dabei entdeckten die Forscher bemerkenswerte Unterschiede zwischen den Geschlechtern. Frauen reagieren zum Beispiel deutlich positiver darauf, wenn ihnen das Fahrzeug im Stau entspannende Musik zuspielt – oder es nach einem knappen Ausweichmanöver beruhigende Worte wie "Reg dich nicht auf" von sich gibt. Männer hingegen wollen offenbar vor allem eins: in Ruhe gelassen werden.

Ob also Google mit seiner Form der Interaktion gut beraten ist? Sein Navigationsprogramm Maps schlägt neuerdings automatisch beruhigende Musik vor, sobald jemand in einen Stau gerät. Es setzt einfach voraus, dass Menschen im Stau automatisch schlechte Laune bekommen – und passende Musik sie behebt.

(grh)