Datenschutzkonformes KI-Training sicherstellen – so geht's

KI-Trainigsdaten enthalten oft personenbezogene Daten. Mit Differential Privacy und Generative Adversarial Networks lassen sie sich vor Missbrauch schützen.

- Marco Barenkamp

Fragen des Datenschutzes sind oft eine Herausforderung für den Einsatz von KI. Ein großes Problem beim Training von KI besteht in potenziellen Verletzungen der Privatsphäre, da man beim KI-Training oft riesige Datenmengen sammelt, die persönliche Informationen von Menschen enthalten. Die Systeme verarbeiten diese Daten, um Muster und Trends zu erkennen.

Dabei besteht die Gefahr, dass sensible Informationen aus den Trainingsdaten herausgefiltert werden, ohne dass die betroffenen Personen davon Kenntnis erlangen oder dies kontrollieren können. Wenn man diese sensiblen Informationen nicht angemessen schützt oder anonymisiert, können sie in die falschen Hände geraten oder für unerwünschte Zwecke verwendet werden.

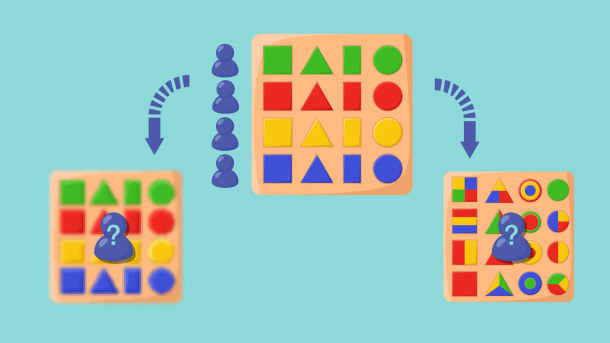

Mit Differential Privacy und Generative Adversarial Networks (GANs) gibt es zwei vielversprechende Verfahren, um datenschutzrechtliche Anforderungen bereits beim Training der KI zu erfüllen. Anhand des Einsatzes dieser Verfahren im Bereich des autonomen Fahrens lässt sich exemplarisch zeigen, wie sie einen entscheidenden Beitrag leisten können.

Das war die Leseprobe unseres heise-Plus-Artikels "Datenschutzkonformes KI-Training sicherstellen – so geht's". Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.