Deep Learning: Wie Compiler dabei helfen, Modelle auf Hardware zu optimieren

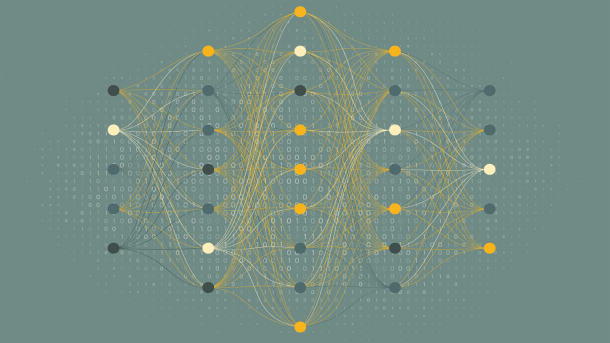

Um Deep-Learning-Modelle auf unterschiedlicher Zielhardware effizient einzusetzen, nutzen Compiler wie TensorFlow XLA und Apache TVM den LLVM-Compilerstack.

- Ramon Wartala

Das LLVM-Projekt hat nicht nur ein allseits etabliertes Compilerframework für die Übersetzung von Hochsprachen in Maschinensprachen auf unterschiedlichen Prozessorarchitekturen hervorgebracht. Immer stärker wird es auch für das Optimieren von Machine-Learning-Modellen eingesetzt.

Der spezielle Zwischencode von LLVM hilft dabei, hardwarespezifische Funktionen und Datenstrukturen von Deep-Learning-Modellen auf unterschiedlicher Zielhardware optimal ausführbar zu übersetzen. Sowohl Open-Source- als auch kommerzielle Produkte buhlen um die Gunst der Datenwissenschaftler und Hersteller spezifischer KI-Hardware.

Anders als Hochsprachen programmiert man Machine-Learning-Modelle nicht, sondern trainiert sie. Große Deep-Learning-Modelle werden dabei nicht auf der Zielhardware trainiert, auf der sie laufen sollen, sondern auf großen GPU-Clustern in der Cloud oder im HPC-Bereich des eigenen Rechenzentrums. Das Modelltraining stellt ganz andere Anforderungen an die Hardware als die Ausführung der trainierten Modelle.

Das war die Leseprobe unseres heise-Plus-Artikels "Deep Learning: Wie Compiler dabei helfen, Modelle auf Hardware zu optimieren". Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.